一、场景

针对主机新增组件或者单独新增主机,下发hadoop客户端自动部署及认证组件,支持新增组件或主机上访问hadoop集群;例

:云翼平台在订购产品的时候,发现对应产品组件需要访问hadoop集群,但是对应的主机上没有Hadoop客户端,此时如果需要专业人员部署,会增加组件订购的难度、人力成本、时间成本,为了保证在订购产品能一键式处理,在订购该产品时候,默认勾选对应的hadoop客户端自动部署及认证组件,可实现同时订购和部署,增加用户的体验感,同时可以节约人力成本和时间成本。

二、解决问题

1、解决新增组件依赖hadoop集群短时间不可用的问题,做到一键自动部署及认证;

2、解决新增主机自动支持访问hadoop集群的问题,即任何主机可单独自动部署及认证;

3、解决现有新增主机需要专业的人员部署hadoop客户端,提升效率。

三、流程

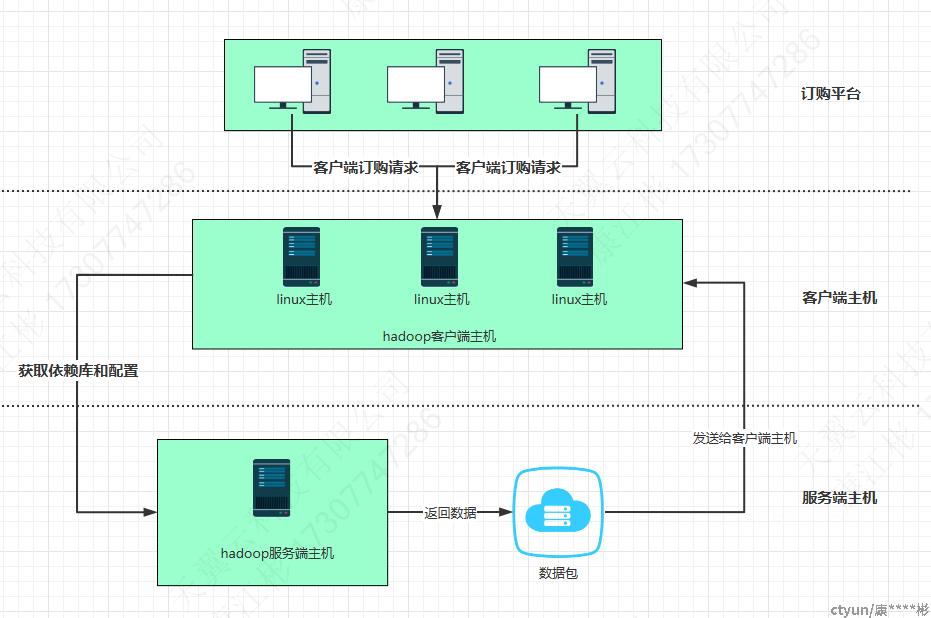

1、系统部署图:

1.1 订购平台:用户通过订购平台发起订购需求。

1.2 Linux主机:负责接收客户端 的订购请求,并向hadoop服务器主机发起获取依赖库和配置请求。

1.3 Hadoop服务器主机:获取并返回依赖库、 kerberos认证文件以及配置数据包。

1.4 数据包:包含了访问hadoop集群的依赖库、java配置、集群配置,同时也提供C语言访问hadoop的头文件和库、java包和接口等。

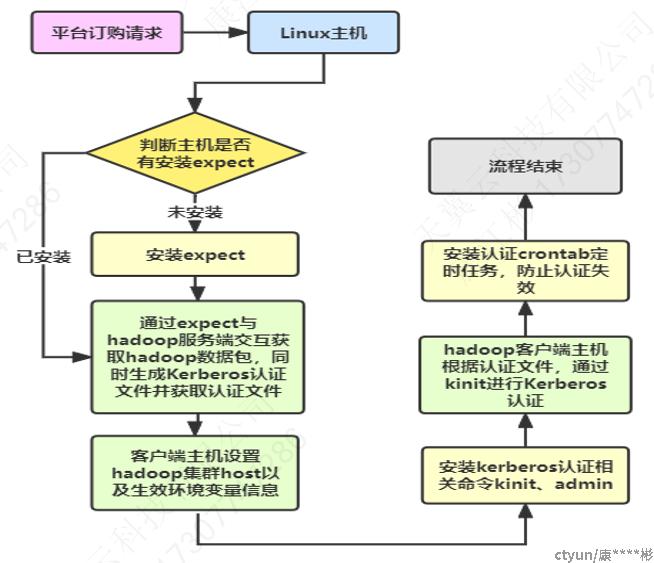

2、流程图:

主要流程:

平台发起订购请求之后,linux主机接收到请求,判断主机是否安装有expect交互命令,如未安装则自动安装,通过expect与hadoop服务端交互获取hadoop数据包,同时生成Kerberos认证文件并获取认证文件,客户端设置hadoop集群信息和环境变量、安装kerberos认证命令以及自动认证,最后安装定时任务,防止隔天认证失效。