MirrorMaker发展历程

MirrorMaker是Apache Kafka中的一个工具,用于在不同的Kafka集群之间进行数据复制和数据同步。它可以将一个Kafka集群中的主题(topic)的数据复制到另一个Kafka集群中的相应主题,从而实现数据的跨集群复制。

MirrorMaker最初是由LinkedIn开发的,作为其内部使用的数据复制工具。LinkedIn是一个职业社交网络平台,使用Kafka作为其核心的消息传递系统。为了实现数据的跨集群复制和数据同步,LinkedIn团队开发了MirrorMaker。

MirrorMaker于2012年首次发布,作为LinkedIn的开源项目,成为Apache Kafka的一部分。随着Kafka的快速发展和广泛应用,MirrorMaker也逐渐得到了更多社区的关注和贡献。

随着时间的推移,MirrorMaker经历了多个版本的更新和改进。在不同的Kafka版本中,MirrorMaker的功能和性能都得到了不断优化和增强。社区也提供了丰富的文档和示例,以帮助用户更好地理解和使用MirrorMaker。

MirrorMaker的历史可以追溯到Kafka的早期发展阶段,它在Kafka生态系统中扮演着重要的角色,为用户提供了可靠的数据复制解决方案。随着时间的推移,MirrorMaker在Kafka社区中得到了广泛的认可和应用,并成为了许多企业在构建分布式数据处理系统中的重要组成部分。

主要特色和功能

MirrorMaker的主要特点和功能包括:

- 高可靠性:MirrorMaker使用消费者(consumer)和生产者(producer)来复制数据,保证数据的可靠性和一致性。它会持续地从源集群中读取数据,并将其写入目标集群中的相应主题。

- 异步复制:MirrorMaker的数据复制是异步进行的,即源集群中的数据变化会延迟一段时间后才会在目标集群中出现。这种异步复制方式可以降低对源集群的影响,并提供更好的性能和吞吐量。

- 跨版本复制:MirrorMaker可以在不同版本的Kafka集群之间进行数据复制。这意味着你可以使用不同版本的Kafka,而不必担心数据复制的兼容性问题。

- 灵活的配置:MirrorMaker提供了灵活的配置选项,可以根据需要进行配置。你可以选择复制全部主题或者只复制特定的主题,还可以配置复制的速率和数据过滤等。

- 容错机制:MirrorMaker具有一定的容错机制,当源集群或目标集群出现故障或不可用时,它会尽力保证数据的复制和同步。它会自动重试失败的操作,并提供一些配置选项来处理故障情况。

总之,MirrorMaker是一个用于在不同Kafka集群之间进行数据复制和数据同步的工具。它可以帮助你实现数据的跨集群复制,提高数据的可用性和容灾能力。

工作原理

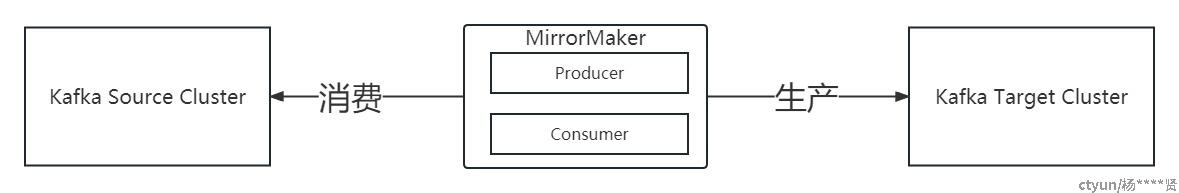

上面是MirrorMaker的简单原理图:在这个图中,有两个Kafka集群:源Kafka集群和目标Kafka集群。源Kafka集群中有多个主题(Topics),每个主题被划分为多个分区(Partitions)。MirrorMaker会从源Kafka集群中的每个主题的每个分区读取数据,并将数据写入目标Kafka集群对应的主题的分区中,从而实现数据的复制和传输。MirrorMaker的工作原理是消费者(Consumer)和生产者(Producer)结合的过程。它通过创建一个或多个消费者实例来从源Kafka集群中读取数据,然后再通过创建相应的生产者实例将数据写入目标Kafka集群。这样,源Kafka集群中的数据会被实时地复制到目标Kafka集群中,保持数据的同步和一致性。这使得MirrorMaker成为了在Kafka集群之间进行数据复制和迁移的重要工具。

MirrorMaker的工作原理可以简单概括为以下几个步骤:

- 配置源集群和目标集群:首先,你需要配置源集群和目标集群的连接信息,包括Kafka集群的地址、主题名称等。MirrorMaker需要同时连接到源集群和目标集群。

- 创建消费者和生产者:MirrorMaker会创建一个或多个消费者,从源集群中读取消息。每个消费者会订阅一个或多个源集群的主题。同时,MirrorMaker也会创建一个或多个生产者,将消息写入目标集群的相应主题。

- 复制消息:MirrorMaker的消费者会从源集群中读取消息,并将其转发给生产者,生产者将消息写入目标集群。复制过程是异步进行的,即源集群中的数据变化会延迟一段时间后才会在目标集群中出现。

- 容错和故障处理:MirrorMaker具有一定的容错机制,当源集群或目标集群出现故障或不可用时,它会尽力保证数据的复制和同步。如果源集群的某个分区不可用,MirrorMaker会尝试从其他可用的分区读取消息。如果目标集群的某个分区不可用,MirrorMaker会重试写入操作,直到成功为止。

- 配置选项:MirrorMaker提供了丰富的配置选项,可以根据需要进行配置。你可以选择复制全部主题或只复制特定的主题,还可以配置复制的速率和数据过滤等。

总之,MirrorMaker通过消费者和生产者的组合,实现了从源集群到目标集群的数据复制和同步。它可以在不同版本的Kafka集群之间进行数据复制,并提供了灵活的配置选项和容错机制,以保证数据的可用性和一致性。

应用场景

Apache Kafka的MirrorMaker有多种实用的应用场景。以下是一些常见的例子:

灾难恢复与冗余:如果你有一个重要的Kafka集群运行在一个数据中心,并且你希望为其创建一个备份,可以使用MirrorMaker将数据复制到另一个位于不同数据中心的Kafka集群。这样,如果主数据中心发生故障,你可以立即切换到备份数据中心,确保业务的连续性。

数据聚合:如果你有多个位于不同地区或部门的Kafka集群,每个集群都在生产重要的数据,你可能希望在一个中心位置进行数据聚合和分析。在这种情况下,可以使用MirrorMaker将所有的Kafka集群的数据复制到一个中心集群。

跨地域应用:如果你的应用需要在多个地域部署,并需要访问到相同的数据流,那么可以使用MirrorMaker在各个地域之间复制数据。

数据管道和ETL:可以在源Kafka集群中创建生产者应用,将数据送入管道,然后在目的地Kafka集群中创建消费者应用,对数据进行处理和存储。MirrorMaker可以在这两个集群之间提供数据流。

注意事项

MirrorMaker虽然是一个强大的工具,但也有一些局限性和潜在的注意事项:

数据传输延迟和一致性:MirrorMaker的复制是异步进行的,因此源Kafka集群中的数据可能存在传输延迟,这意味着目标Kafka集群中的数据不一定实时与源保持一致。在某些情况下,由于网络或其他问题,复制的数据可能会丢失或出现不一致的情况。

不支持数据转换和过滤:MirrorMaker仅仅是简单的数据复制工具,不支持对数据进行转换、过滤或处理。如果需要在复制数据之前对其进行转换或过滤,需要使用其他工具或编写自定义的数据处理逻辑。

无法保证顺序性:由于MirrorMaker是并行复制多个分区,无法保证复制到目标Kafka集群的数据分区顺序与源Kafka集群完全一致。这可能会影响到一些依赖消息顺序性的应用场景。

消费者组管理:在MirrorMaker复制数据时,消费者组的管理可能需要特别注意。由于复制的每个分区都是独立的消费者,如果目标Kafka集群上的消费者组与源集群上的消费者组存在冲突,可能会导致一些问题,如重复消息或消息丢失。

网络带宽和资源消耗:复制大量数据可能会占用大量网络带宽和消耗资源,特别是当源Kafka集群产生大量数据时,可能会对网络和目标Kafka集群的性能产生影响。

维护和监控:使用MirrorMaker进行数据复制后,需要维护和监控两个Kafka集群,确保它们的稳定性和一致性。同时,如果源集群发生故障或出现问题,可能需要手动干预以确保复制的可用性。

为了克服这些局限性,有时候需要考虑其他解决方案,例如使用Kafka Connect等工具,或者根据具体需求编写自定义的数据复制和处理逻辑。