引言

在深度学习的众多模型中,循环神经网络(RNN)因其对序列数据处理的特性而备受关注。无论是自然语言处理、时间序列预测,还是语音识别,RNN都展现出了强大的能力。然而,RNN的内部机制及其在实际应用中的优势与局限性,常常让人感到困惑。本文将深入探讨RNN的基本原理、结构变种及其应用场景,帮助读者更好地理解这一重要的神经网络模型。

一、RNN的基本原理

1.1 RNN的结构

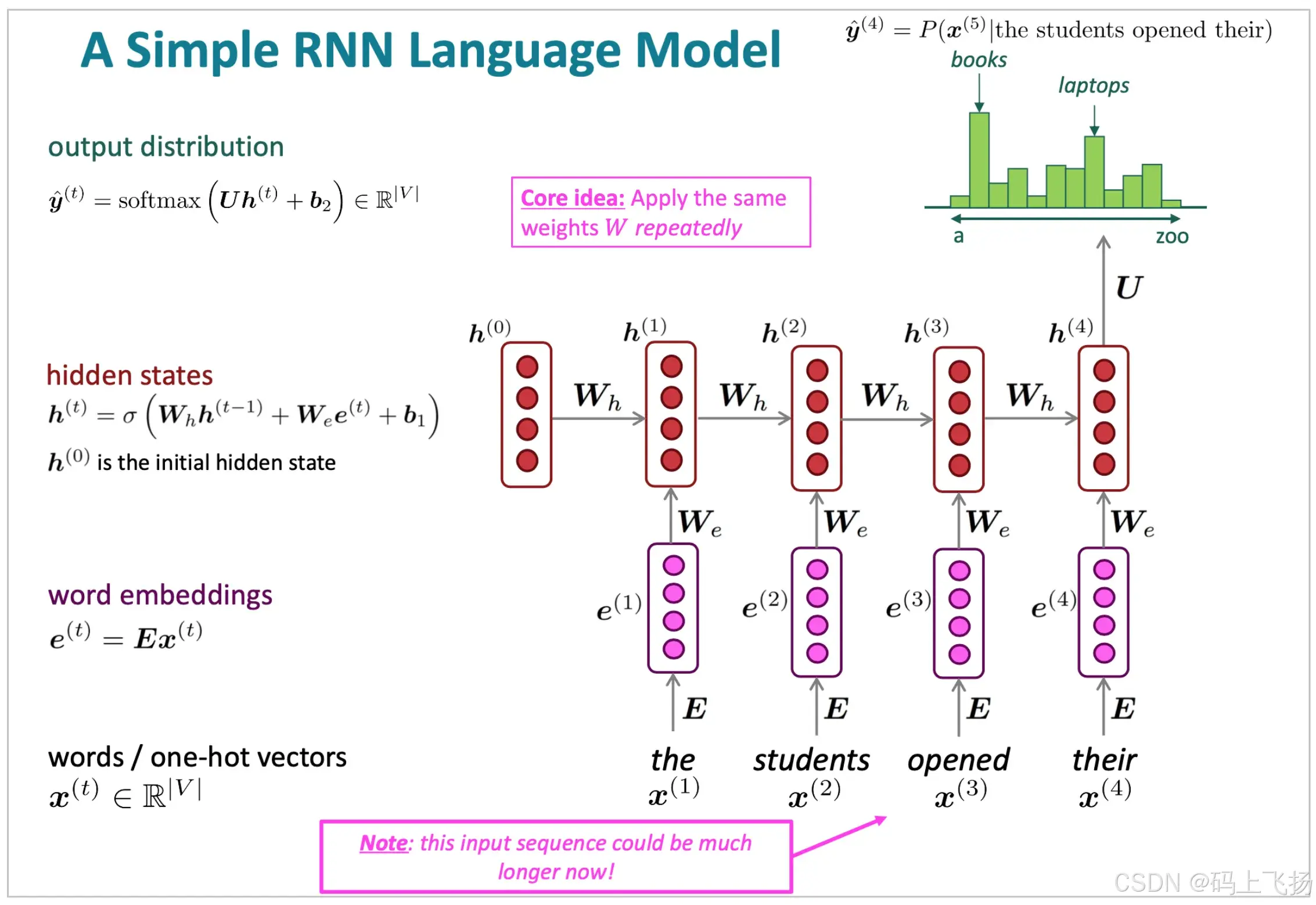

循环神经网络(RNN)是处理序列数据的一种特殊神经网络结构。与传统的前馈神经网络不同,RNN通过循环连接的方式,使得网络能够保留先前时间步的信息,从而形成一种“记忆”能力。这种特性使得RNN能够有效地处理时间序列数据,例如自然语言、音频信号等。

在RNN中,每个时间步的输出不仅依赖于当前输入,还依赖于前一个时间步的隐藏状态(hidden state)。这种结构使得RNN能够捕捉到输入序列中各个元素之间的依赖关系。例如,在处理一句话时,RNN能够记住前面的词汇信息,从而理解当前词汇的上下文。

1.2 数学表达

RNN的数学模型可以通过以下公式进行描述:

-

隐藏状态更新: 在时间步 ( t ) 上,RNN的隐藏状态 ( h_t ) 是由前一时间步的隐藏状态 ( h_{t-1} ) 和当前输入 ( x_t ) 共同决定的。其更新公式为: [ h_t = f(W_h h_{t-1} + W_x x_t + b) ] 其中:

- ( W_h ) 是连接前一隐藏状态和当前隐藏状态的权重矩阵。

- ( W_x ) 是连接当前输入和当前隐藏状态的权重矩阵。

- ( b ) 是偏置项。

- ( f ) 是激活函数,通常使用tanh或ReLU等非线性函数,以引入非线性特性。

-

输出层: RNN的输出 ( y_t ) 是当前隐藏状态 ( h_t ) 和输出层权重矩阵 ( W_y ) 的线性组合,公式为: [ y_t = W_y h_t + b_y ] 其中,( b_y ) 是输出层的偏置项。输出 ( y_t ) 根据任务的不同可以是分类标签、连续值等。

1.3 训练过程

RNN的训练过程通常采用反向传播算法,具体为“反向传播通过时间”(Backpropagation Through Time, BPTT)。在训练过程中,RNN会将整个序列的数据输入网络,并计算每个时间步的损失。然后,利用反向传播算法逐步更新网络的权重和偏置,以最小化损失函数。

由于RNN的时间依赖性,反向传播的过程中会涉及到多个时间步的梯度计算。尽管这种方法能够有效地训练RNN,但在长序列的情况下,梯度消失或爆炸的问题可能会影响训练效果。

1.4 RNN的优缺点

优点:

- 时间依赖性:RNN能够有效地捕捉序列中的时间依赖性,适用于处理变长的输入序列。

- 共享参数:RNN在所有时间步中共享相同的参数,这使得网络能够更高效地进行学习,并减少模型的复杂性。

缺点:

- 梯度消失和爆炸:在长序列训练中,RNN容易出现梯度消失或梯度爆炸的问题,导致模型无法有效学习。

- 计算效率:由于RNN的顺序计算特性,在处理