(接上文)

四、研究方法:

(一)VLM预训练方法:

目前主流的以CLIP为典型代表的VLM预训练方法可以大致分为3个关键模块:

- 文本特征提取模块,通常采用Transformer结构及其一系列变体作为基础结构。

- 图像特征提取模块,通常采用CNN(以ResNet结构为典型代表)或者Transformer(如ViT、MAE等结构)来提取图像特征。

- 特征融合模块。

在VLM预训练模型中,最关键的问题是将文本和图像这两种模态的信息建立联系,所以对其中的特征融合模块做详细介绍。在特征融合模块中,以目标函数进行分类的话,大致可以分为三类目标函数:

- 对比式(Contrastive Objectives);

- 生成式(Generative Objectives);

- 对齐式(Alignment Objectives)。

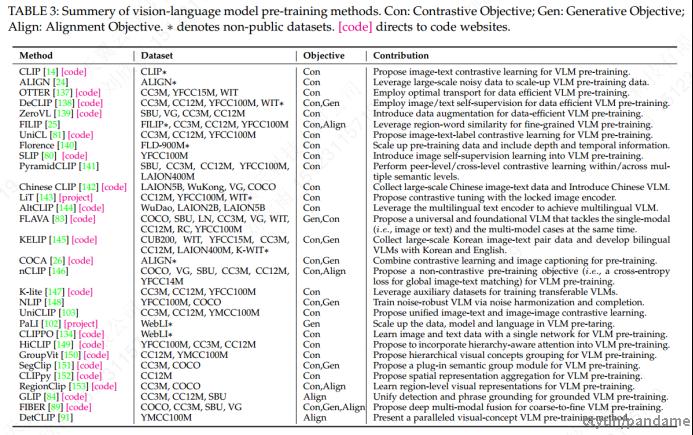

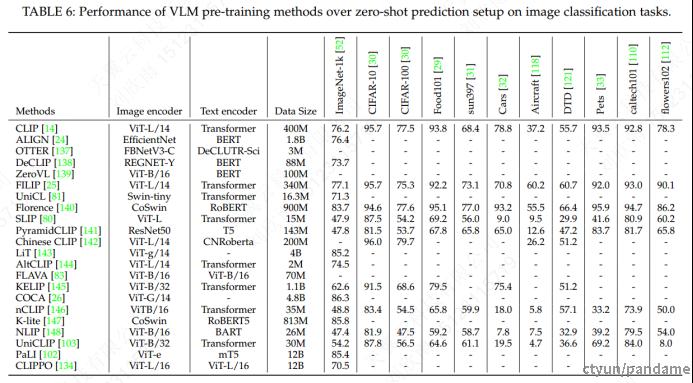

一些常见的VLM预训练方法如下表所示,可以看出典型的目标函数选择按照对应的方法数量多少可以分为以下几种:

- 纯对比式目标函数(18篇文章),以CLIP、ALIGN、SLI等为代表。

- 对比式和生成式相结合(6篇文章),以DeCLIP、FLAVA等为代表。

- 对比式和对齐式相结合(3篇文章),以FILIP、nCLIP、RegionClip为代表。

- 纯对齐式(2篇文章),以GLIP、DetCLIP为代表。

- 纯生成式(1篇文章),以PaLI为代表。

- 对比式、生成式、对齐式相结合(1篇),以FIBER为代表。

(二)典型算法介绍:

1. CLIP:

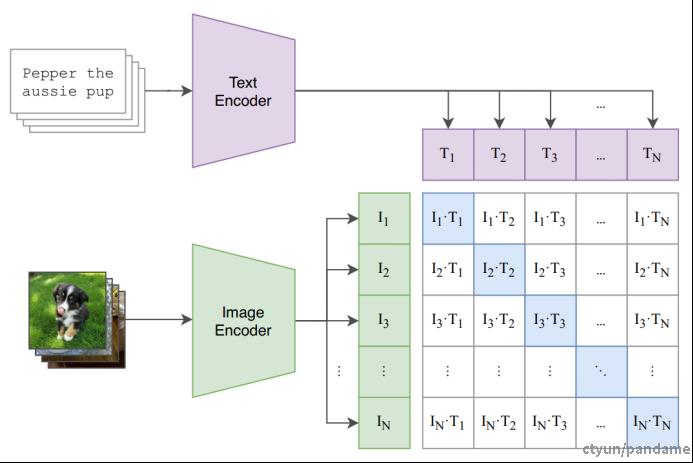

提出用对比学习的方式训练VLM。

关键点:高质量数据集(0.4B图文对);对比学习。

采用这种对比式学习来进行VLM建模的开山鼻祖,数据集规模为0.4B。

采用对比学习的方式,其中:

- Text Encoder, 采用GPT-2的结构。

- Image Encoder, 采用了两种方式:ResNet的改进;ViT略微修改。

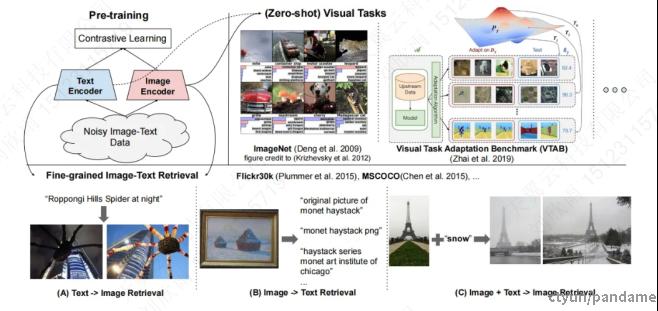

2. ALIGN:

利用大规模噪声数据去扩展VLM。

关键点:大规模数据集(1.8B)。数据集规模为1.8B,并且包含大量噪声。

采用对比学习的方式,其中:

- Text Encoder, BERT结构。

- Image Encoder, EfficientNet结构。

- 特征融合:对比学习,采用和CLIP类似的损失函数,不过加了temperature variable。

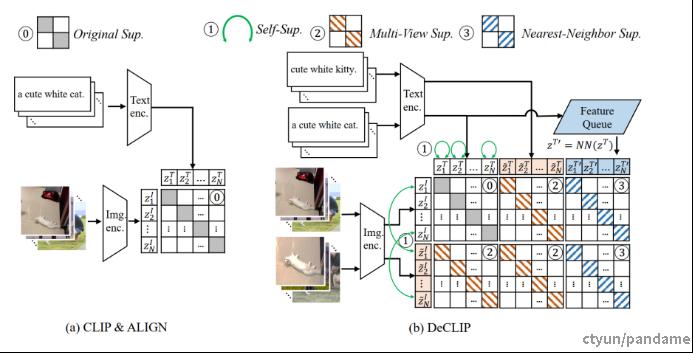

3. DeCLIP:

用各种监督信息来进行数据高效的VLM预训练(Data Efficient CLIP)。

论文指出CLIP需要大量数据(0.4B图像文本对)进行训练,因此限制了它的广泛采用,于是提出了一种新的训练范式,Data efficient CLIP (DeCLIP),以缓解这种限制。

通过精心利用图像文本对之间的广泛监督,从而更有效地学习通用视觉特征。相比CLIP使用单个图像文本对比监督,DeCLIP采用了多种监督方式去充分利用数据的潜力,使得能够在更少的训练数据量的情况下取得较好的训练效果。

这些额外的自监督信息包括:

- 单个模态内部的自监督:文本的MLM自监督;数据增强的图像对的自监督(让相似性尽可能大);

- 跨模态的多视角监督:文本数据增强之后扩充为2个相似文本,图像数据增强扩充为2个相似图片,这样2x2的组合就可以构造4对正样本对;

- 最近邻监督:利用文本embedding。在特征队列里的最近邻,与2张图片,又可以构造额外的两对正样本对。

(三)算法效果对比:

比较各个VLM预训练模型的能力,在所有任务(包括图像分类、分割、目标检测)上都是比较的zero-shot的结果。

预训练的VLM能够在下游任务中取得较好的zero-shot结果,具备优秀的泛化性能。这得益于三大因素:

- 大数据——采用图文对这种监督方式,更方便收集大量数据进行训练(如LiT中的4B数据和COCA中的4.8B数据),使得VLM具有强大的泛化能力;

- 大模型——与传统的视觉识别模型相比,VLM通常采用更大的模型(例如COCA中的ViT-G,有2B个参数),这些模型提供了足够的容量来有效地从大数据中学习;

任务无关学习——VLM预训练中的监督通常是通用和任务无关的。与传统视觉识别中的任务特定标签相比,图像文本对中的文本提供了任务无关、多样化和信息丰富的语言监督,有助于训练出适用于各种下游任务的可泛化模型。

1. 分类任务:

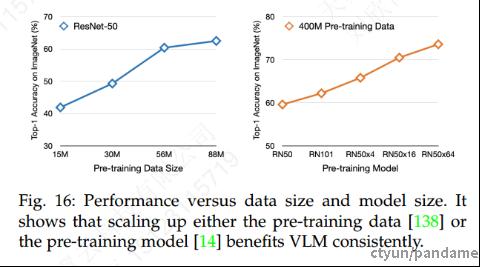

从下表和下图可以看出:

- 预训练数据规模越大,效果越好;

- 模型规模越大,效果越好;

在大规模的图像-文本训练数据下,VLM可以在各种下游任务上实现卓越的零样本性能。

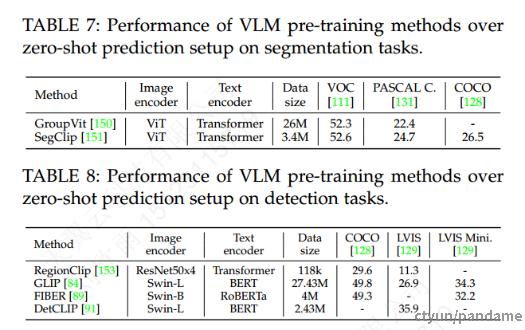

2. 分割、目标检测任务:

某些VLM会使用本地VLM预训练目标(例如区域-词匹配),对VLM进行目标检测和语义分割的预训练。从下面两个表可以观察到,VLM在这两个任务上也能实现有效的zero-shot预测。不过各个模型的效果并不完全满足分类任务中提及的“数据越多效果越好,模型越大效果越好”的规律。相信随着这一领域的不断研究突破,应该逐渐会朝着这个趋势去发展。

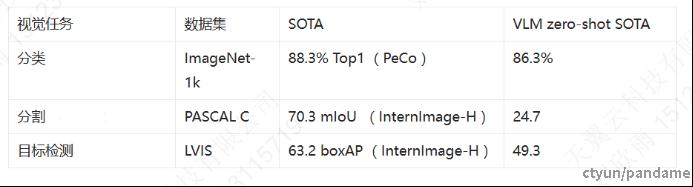

因此,结合以上可以看出:VLM 在分类任务上的zero-shot结果已经和SOTA不相上下,而在目标检测、分割模型上则还有较大差距。

五、商业化CV大模型:

1.百度文心 UFO 2.0:

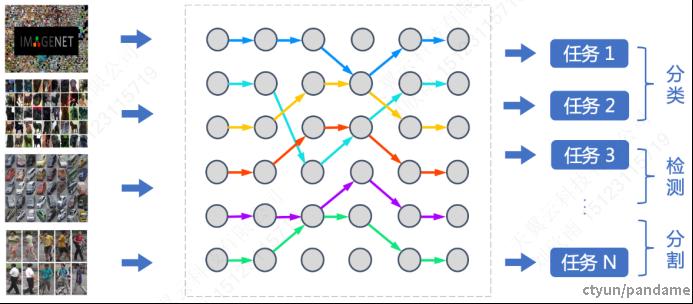

针对预训练大模型落地所面临的问题,百度提出统一特征表示优化技术(UFO:Unified Feature Optimization),在充分利用大数据和大模型的同时,兼顾大模型落地成本及部署效率。VIMER-UFO 2.0 技术方案的主要内容包括:

- All in One:行业最大 170 亿参数视觉多任务模型,覆盖人脸、人体、车辆、商品、食物细粒度分类等 20+ CV 基础任务,单模型 28 个公开测试集效果是 SOTA;

- One for All:首创针对视觉多任务的超网络与训练方案,支持各类任务、各类硬件的灵活部署,解决大模型参数量大,推理性能差的问题。

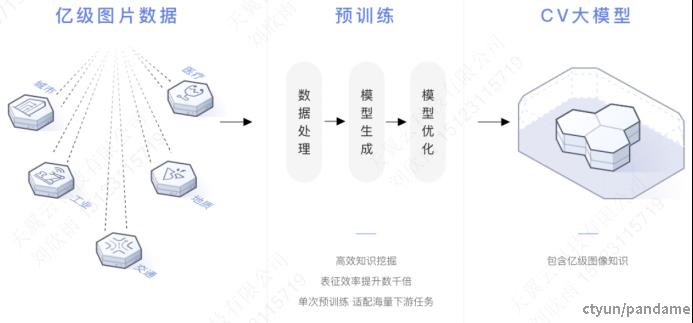

2.华为 盘古CV视觉大模型:

2021年4月份华为发布盘古系列大模型,首次实现模型按需抽取的业界最大CV大模型,首次实现兼顾判别与生成能力。

基于模型大小和运行速度需求,自适应抽取不同规模模型,AI应用开发快速落地。使用层次化语义对齐和语义调整算法,在浅层特征上获得了更好的可分离性,使小样本学习的能力获得了显著提升,达到业界第一。盘古CV大模型实现了:

- 当时业界最大CV模型;

- 判别与生成联合预训练;

- 100+场景验证;

- 小样本学习性能领先。

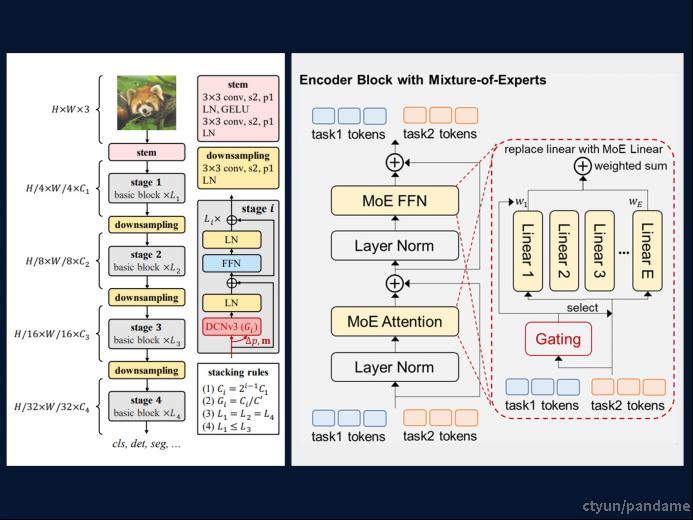

3.商汤 书生(INTERN)2.5:

2023年3月14日,商汤科技发布多模态多任务通用大模型“书生(INTERN)2.5”,在多模态多任务处理能力方面实现多项全新突破,其卓越的图文跨模态开放任务处理能力可为自动驾驶、机器人等通用场景任务提供高效精准的感知和理解能力支持,向通用人工智能迈出坚实的一步。“书生(INTERN)”最初版本由商汤科技、上海人工智能实验室、清华大学、香港中文大学、上海交通大学在2021年11月首次共同发布,并持续联合研发。

“书生”(INTERN)体系旨在系统化解决当下人工智能视觉领域中存在的任务通用、场景泛化和数据效率等一系列瓶颈问题。全新的通用视觉技术体系命名为“书生”,意在体现其如同书生一般的特质,可通过持续学习,举一反三,逐步实现通用视觉领域的融会贯通,最终实现灵活高效的模型部署。“书生”通用视觉技术将实现以一个模型完成成百上千种任务,体系化解决人工智能发展中数据、泛化、认知和安全等诸多瓶颈问题。

六、未来研究方向:

VLM技术能够有效地利用大量容易收集的互联网数据进行训练,从而无需进行任何任务特定的微调实现zero-shot的预测,并且能够对任意类别的图像进行开放词汇的视觉识别,是一个很有潜力的研究方向。下面列举的是一些VLM研究领域当前存在的一些挑战和潜在的研究方向。

1.VLM预训练:

- 细粒度的视觉-语言相关性建模。通过本地的视觉-语言对应关系知识,VLMs能够更好地识别图像中的小块和像素,从而在目标检测和语义分割等密集预测任务中产生显著的好处。未来可以加强在这一方向上的VLM研究,尤其是零样本密集预测任务的细粒度VLM预训练。

- 统一视觉和语言学习。Transformer的出现使得在单一Transformer内部对图像和文本进行分词从而实现图像和文本的统一学习成为可能。与现有的VLMs中采用两个独立的网络不同,将视觉和语言学习统一起来可以在训练效果和效率上都能够受益。未来可以进一步研究实现更加高效的跨模态的统一VLMs。

- 多语言预训练VLMs。目前大多数VLMs都是通过单一语言进行训练的,这可能会引入文化和地区的偏见,并限制了VLM在其他语言区域的应用。通过使用多语言文本进行VLMs的预训练,可以让VLMs学习到不同语言中相同词汇的不同文化视觉特征,从而在不同语言场景中高效地工作。未来可以加强多语言VLMs的研究。

- 数据效率高的VLMs。目前大部分VLMs的训练都需要大规模的训练数据和密集的计算资源。然而,在许多应用场景中,数据量可能是有限的,因此需要开发出数据效率高的VLMs,能够在少量数据的情况下实现高效的视觉-语言联合学习。这是一个有待深入研究的方向。

2.VLM迁移学习:

- 无监督VLM迁移学习。目前大部分VLM迁移研究都在有监督或少样本有监督的情境下进行,需要标注数据,但这容易导致过拟合。无监督的VLM迁移可以在探索大规模未标注数据时降低过拟合的风险。预计在未来的VLM研究中,会有更多关于未监督VLM迁移的研究。

- 使用visual prompt/adapter的VLM迁移学习。目前大多数VLM迁移研究都专注于text prompt,而采用visual prompt或visual adapter可能更容易在各种密集预测任务中实现像素级的适应。未来可以预期在视觉领域会有更多的VLM迁移研究。

- Test-time VLM迁移学习。目前大多数研究通过在每个下游任务(例如提示学习)上对VLM进行微调来进行迁移,导致在面对多个下游任务时需要重复训练。Test-time VLM迁移允许在推理期间动态调整提示,避免了现有VLM迁移中的重复训练。可以预见到在测试时VLM迁移方面会有更多的研究。

3.VLM知识蒸馏:

- 利用多个VLM进行知识蒸馏,采用一定的组合方式实现不同VLM的协同,去提升任务效果。

- 将VLM蒸馏方法扩展到更多任务。

七、总结:

用于视觉识别的视觉语言模型(VLM)能够有效地使用网络数据,并允许零样本预测,而无需特定于任务的微调,在广泛的识别任务中取得了巨大的成功。本报告从VLM的研究背景、研究意义、理论框架、技术方法、商业化大模型和未来的研究方向等几个方面对VLM进行了调研,并将不同的算法进行了比较总结。

八、参考文献:

- Zhang, Jingyi, et al. "Vision-Language Models for Vision Tasks: A Survey." arXiv preprint arXiv:2304.00685 (2023).

- On the Opportunities and Risks of Foundation Models[J]. 2021.DOI:10.48550/arXiv.2108.07258.

- Vaswani, Ashish, et al. “Attention Is All You Need.” Neural Information Processing Systems,Neural Information Processing Systems, June 2017. (Transformer)

- Dosovitskiy, Alexey, et al. “An Image Is Worth 16x16 Words: Transformers for Image Recognition at Scale.” arXiv: Computer Vision and Pattern Recognition, arXiv: Computer Vision and Pattern Recognition, Oct. 2020.(ViT)

- He, Kaiming, et al. “Masked Autoencoders Are Scalable Vision Learners.” 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2022.(MAE)

- Cao, Yihan, et al. "A comprehensive survey of ai-generated content (aigc): A history of generative ai from gan to chatgpt." arXiv preprint arXiv:2303.04226 (2023).

- Radford, Alec, et al. "Learning transferable visual models from natural language supervision." International conference on machine learning. PMLR, 2021. (CLIP)

- Jia, Chao, et al. "Scaling up visual and vision-language representation learning with noisy text supervision." International Conference on Machine Learning. PMLR, 2021. (ALIGN)

- Li, Yangguang, et al. "Supervision exists everywhere: A data efficient contrastive language-image pre-training paradigm." arXiv preprint arXiv:2110.05208 (2021). (DeCLIP)

- Singh, Amanpreet, et al. "Flava: A foundational language and vision alignment model." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022. (FLAVA)