一、这仨 “小伙伴” 到底啥来头?

(一)科研助手:息壤平台里的 “科研小机灵鬼”

天翼云息壤平台是一体化智算服务领域的关键平台,它致力于打造全国一体化算力网络,把各种异构算力资源整合起来,为各类计算任务提供算网调度、计算加速、模型训练与推理等服务 ,就像是一个强大的 “资源中枢”。而基于此平台的科研助手,可是息壤平台里的 “秘密武器”,专门为解决科研路上的 “疑难杂症” 而生。高校科研团队平时遇到的算力分散、不够用,还有找科研软件费老劲这些让人头疼的问题,它都能轻松搞定。它就像一个贴心的科研小助手,不仅能给你安排充足的算力资源,还能根据不同科研场景,帮你搭建好合适的科研环境,有它在,科研都变得更轻松啦!

(二)Bitnet:模型推理界的 “蚁人”

BitNet 大模型是一种超低比特量化(1-bit/1.58-bit)的大型语言模型(LLM),其核心目标是通过极致的模型压缩技术,显著降低计算资源需求,使大模型能够在普通 CPU 设备上高效运行,无需依赖高性能 GPU。BitNet 代表了低比特量化 LLM 的前沿方向,通过算法创新和工程优化,实现了“小体积、高性能、低功耗”的平衡。其开源框架进一步推动了 AI 技术的民主化,未来可能在移动端、嵌入式系统等领域引发广泛变革。

二、部署大模型,就这么简单!

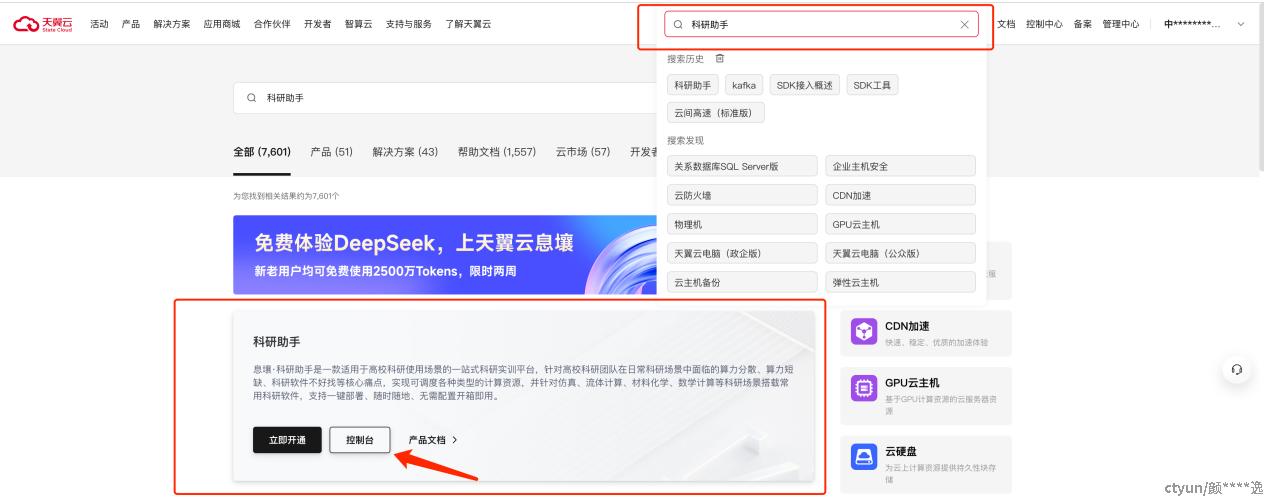

(一)找到科研助手

首先,咱们打开天翼云官网,在页面上找到搜索栏,输入 “科研助手”,就能顺利找到科研助手控制台的 “大门” 啦。

(二)创建专属开发机

进入科研助手界面后,往左边看,找到开发机菜单栏,点击 “创建开发机”。在资源配置的时候,只需要低成本的普通 CPU 型即可加载Bitnet模型!

选好资源配置后,再挑框架版本。由于bitnet运行环境依赖conda,在科研助手公共框架的镜像里很多的框架都预装了conda,例如下图中的模型开发框架,选好之后,点击确认订单,开发机就开始 “建造” 啦!

刚建好的开发机还需要 “热热身”,也就是预热,预热进度可以在 Pod 信息里查看。一般来说,镜像拉取这一步大概要花 1 - 3 分钟,请耐心等待。预热成功后,就可以点击进入开发机。

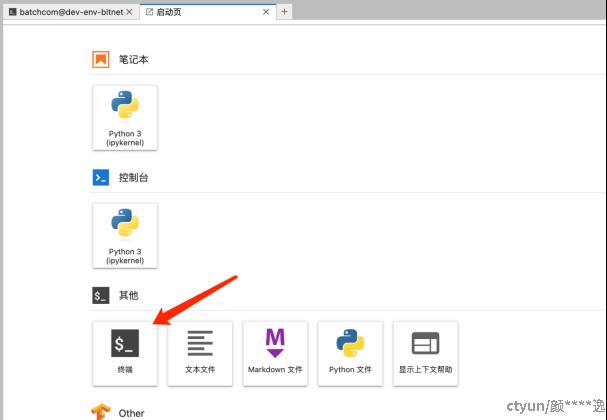

(三)运行Bitnet

进入开发机界面后,启动控制台,准备bitnet模型运行所需的软件环境

1)输入:

git clone --recursive https://github.com/microsoft/BitNet.git

下载模型运行时依赖环境。

2)输入:

mkdir BitNet-b1.58-2B-4T && cd BitNet-b1.58-2B-4T

wget [https://huggingface.co/microsoft/bitnet-b1.58-2B-4T-gguf/resolve/main/ggml-model-i2\_s.gguf?download=true](https://huggingface.co/microsoft/bitnet-b1.58-2B-4T-gguf/resolve/main/ggml-model-i2_s.gguf?download=true)

下载模型文件

3)输入:

conda create -n bitnet-cpp python=3.9

conda activate bitnet-cpp

pip install -r requirements.txt

创建conda环境并安装相关依赖

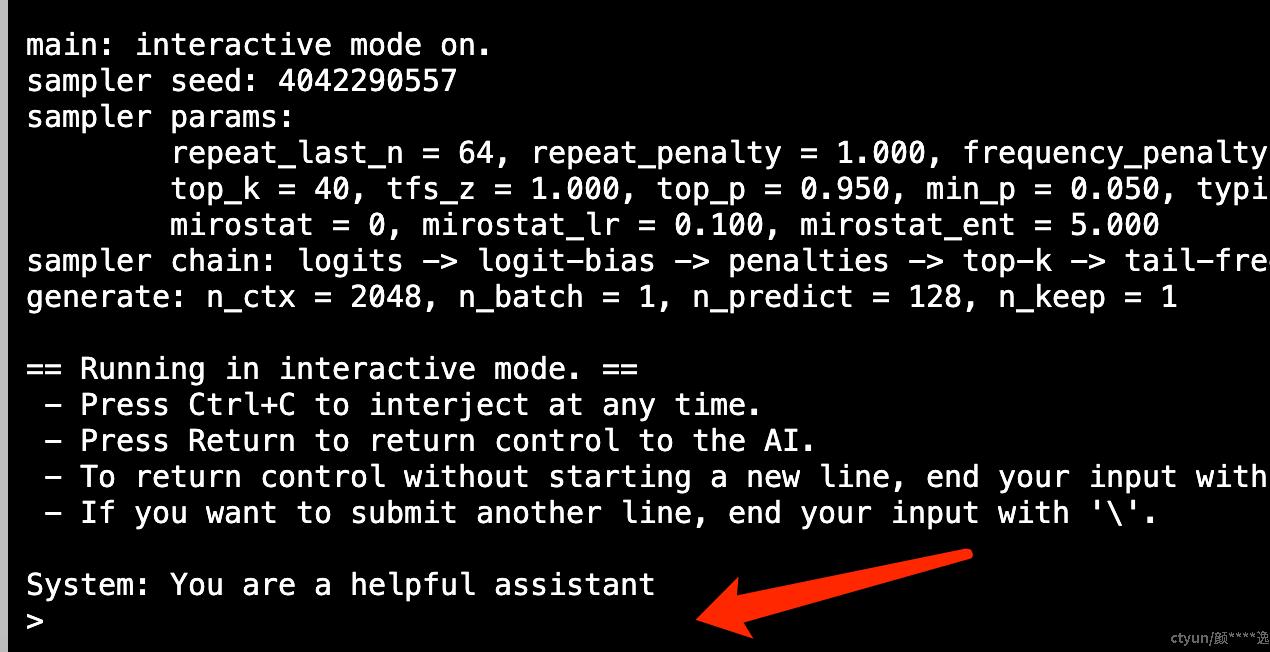

4)输入:

cd BitNet

python run\_inference.py -m ../BitNet-b1.58-2B-4T/ggml-model-i2\_s.gguf -p "You are a helpful assistant" -cnv

即可开启与Bitnet的对话

三、未来可期,一起向 AI 的星辰大海出发!

天翼云科研助手与BitNet的协作,彻底击碎了大模型部署的“资源紧箍咒”,在效率、成本、能耗三重维度上达成完美平衡。科研助手以普惠算力为基,BitNet以量化创新为刃,共同推动AI技术迈向“低耗高效”的新纪元。

未来,这一组合必将在智能制造、实时翻译、物联网AI等领域大放异彩,助力全球研究者以最小资源消耗,撬动最大智能潜能。在AI星辰大海的征途中,天翼云科研助手将与BitNet并肩前行,为每一次技术“狂飙”注入持久动力!

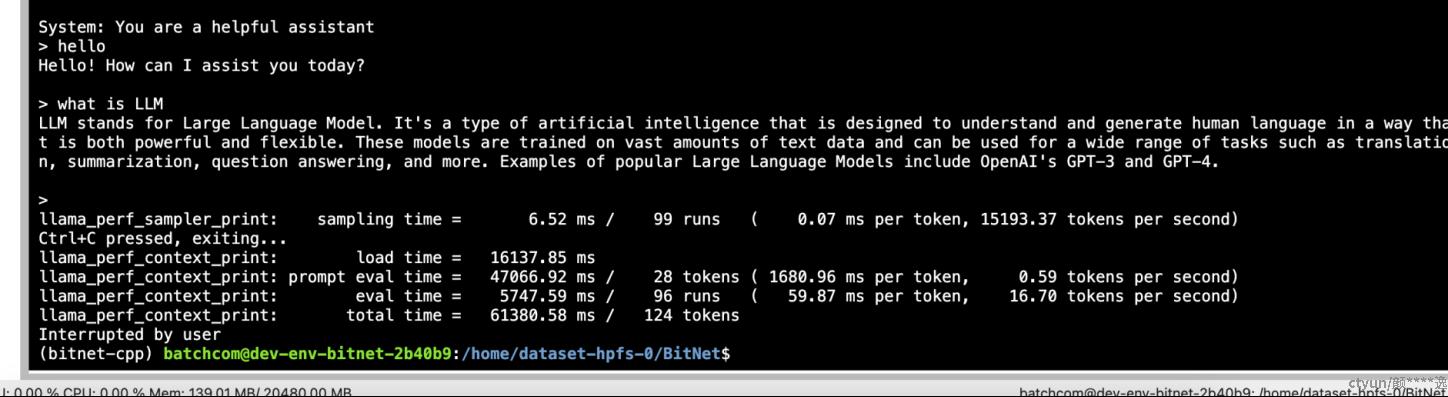

四、cpu性能测试

可以看到,在CPU上运行的bitnet模型也有较好的性能,token生成速度16.70t/s超过了正常的阅读速度,使用较为流畅