1. normalization干啥的?

Normalization 的作用是数据拉回标准正态分布,因为神经网络的Block大部分都是矩阵运算,一个向量经过矩阵运算后值会越来越大,为了网络的稳定性,我们需要及时把值拉回正态分布。

2. normalization分类

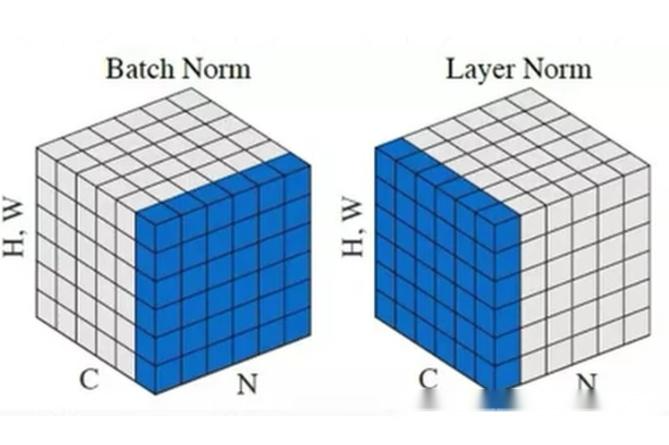

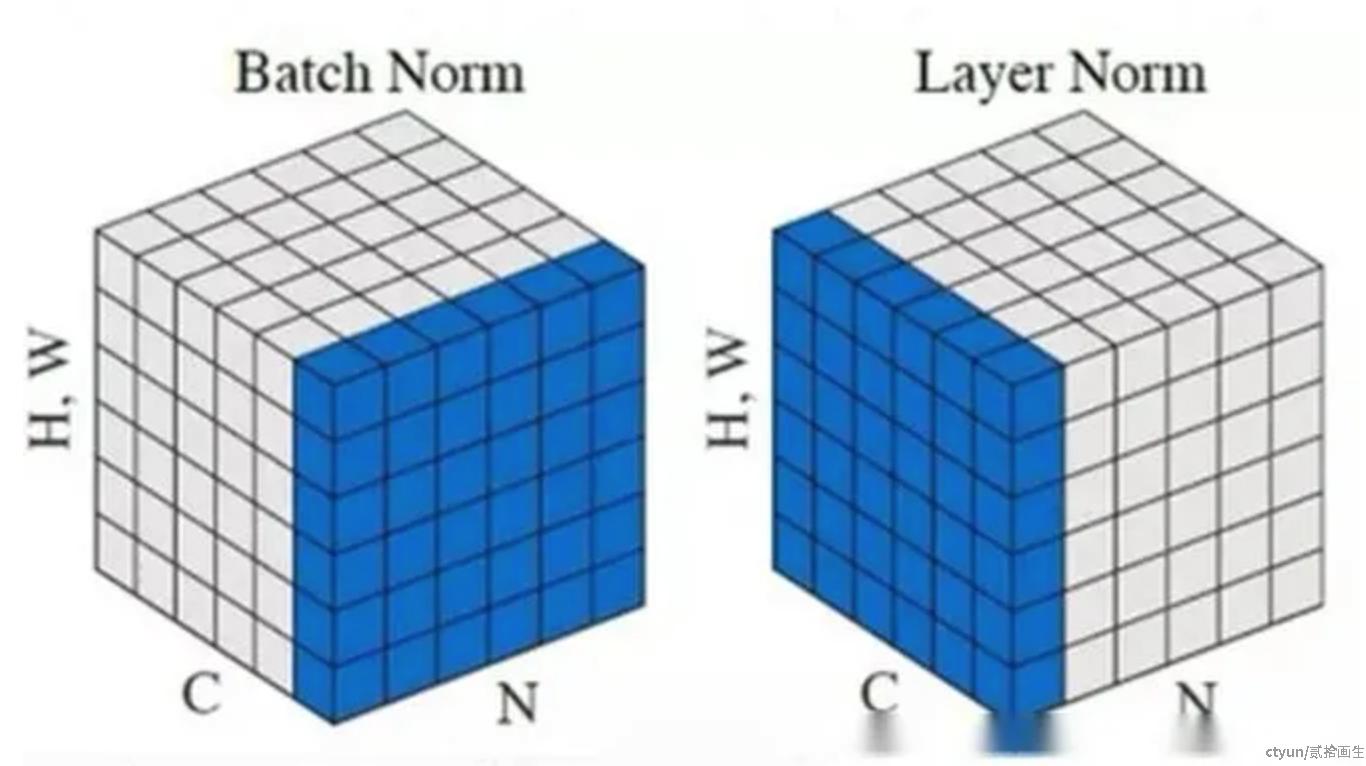

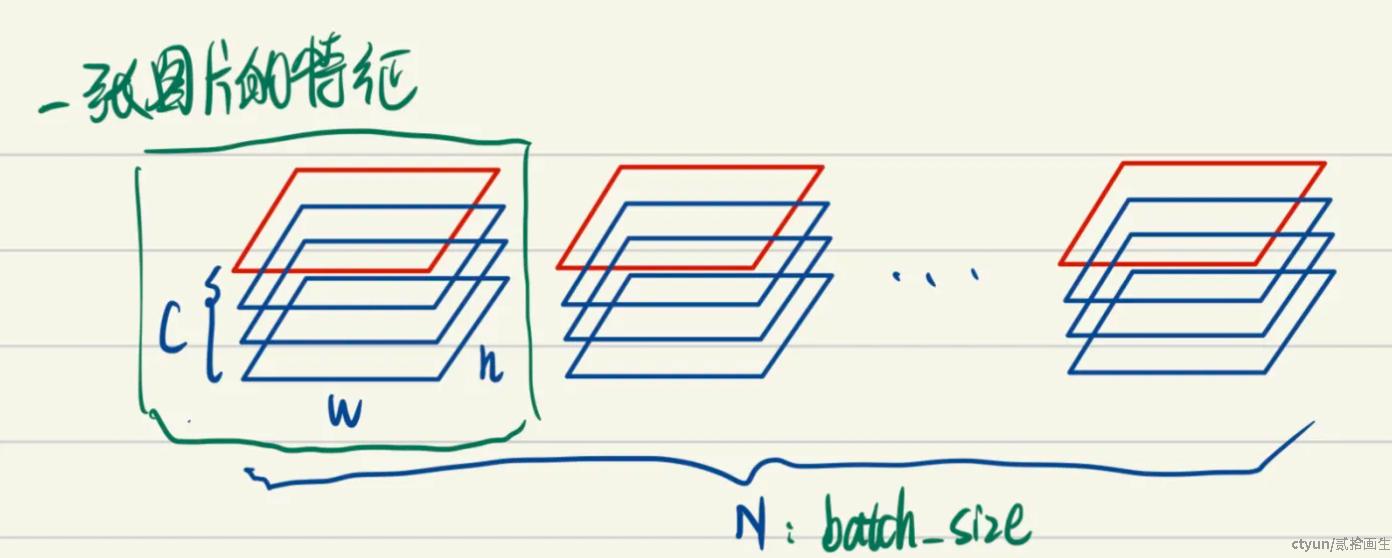

根据标准化操作的维度不同,可将normalization分类成Batch Normalization 和 Layer Normalization,BatchNorm一般用于CV领域,而LayerNorm一般用于NLP领域;BatchNorm就是通过对batch size这个维度归一化来让分布稳定下来。LayerNorm则是通过对Hidden size这个维度归一化来让某层的分布稳定。

BatchNorm是对一个batch-size样本内的每个特征做归一化,LayerNorm是对每个样本的所有特征做归一化。BN 的转换是针对单个神经元可训练的:不同神经元的输入经过再平移和再缩放后分布在不同的区间;而 LN 对于一整层的神经元训练得到同一个转换:所有的输入都在同一个区间范围内。如果不同输入特征不属于相似的类别(比如color和大小),那么 LN 的处理可能会降低模型的表达能力。

3. 区别和理解

BatchNorm把一个batch中同一通道的所有特征(如上图red区域)视为一个分布(有几个通道就有几个分布),并将其标准化。这意味着:

- 不同图片的的同一通道的相对关系是保留的,即不同图片的同一通达的特征是可以比较的

- 同一图片的不同通道的特征则是失去了可比性

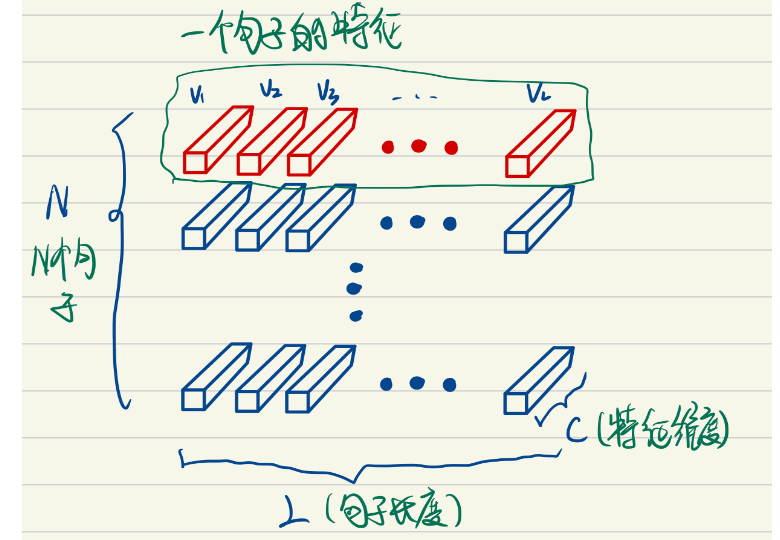

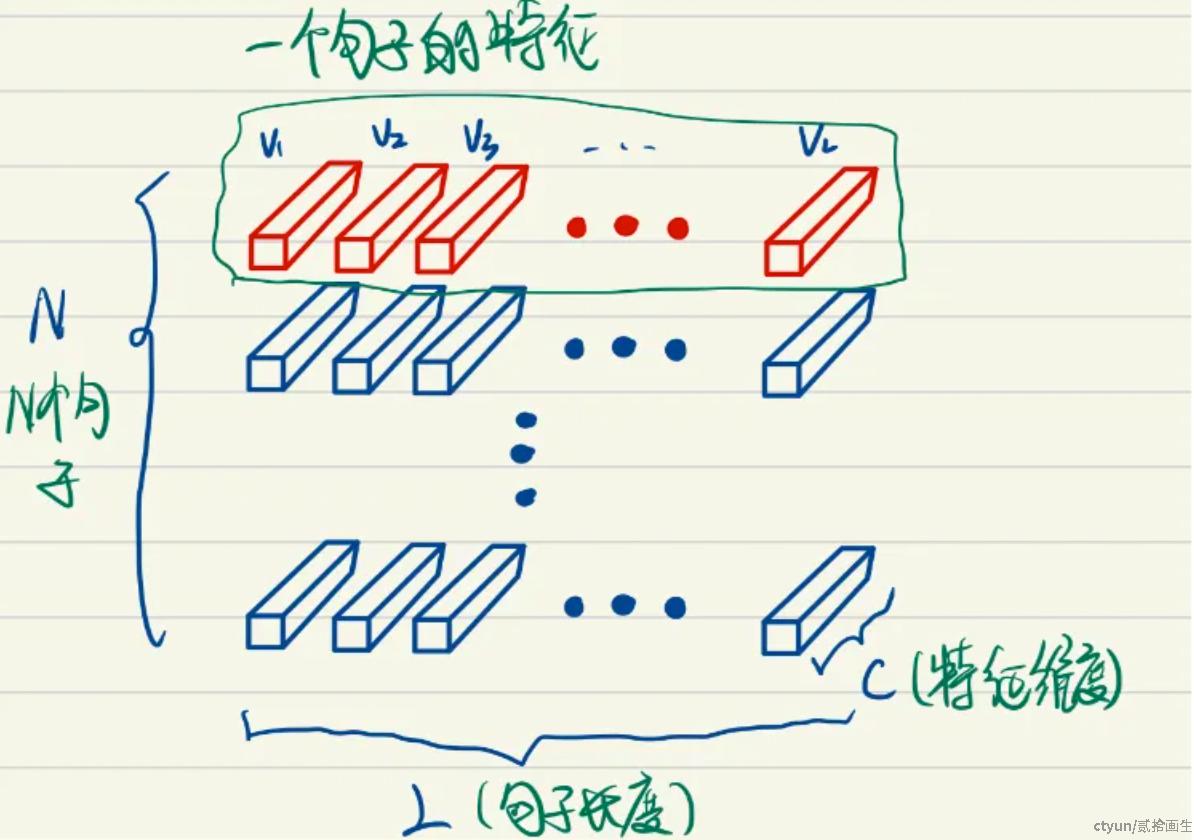

如上图为N个句子的语义特征张量,LayerNorm把一个样本的所有词义向量(如上图red部分)视为一个分布(有几个句子就有几个分布),并将其标准化。这意味着:

- 同一句子中词义向量(上图中的V1, V2, …, VL)的相对大小是保留的,或者也可以说LayerNorm不改变词义向量的方向,只改变它的模。

- 不同句子的词义向量则是失去了可比性。

4. 为什么RNN 或Transformer为什么用Layer Normalization?

首先RNN或Transformer解决的是序列问题,一个存在的问题是不同样本的序列长度不一致,而Batch Normalization需要对不同样本的同一位置特征进行标准化处理,所以无法应用;当然,输入的序列都要做padding补齐操作,但是补齐的位置填充的都是0,这些位置都是无意义的,此时的标准化也就没有意义了。

其次,BN抹杀了不同特征之间的大小关系;LN是保留了一个样本内不同特征之间的大小关系,这对NLP任务是至关重要的。对于NLP或者序列任务来说,一条样本的不同特征,其实就是时序上的变化,这正是需要学习的东西自然不能做归一化抹杀,所以要用LN。