MapReduce服务(MapReduce Service,简称MRS)提供企业级大数据集群云服务,里面包含HDFS、Hive、Spark等组件,适用于企业海量数据分析。

其中Hive提供类SQL查询语言,帮助用户对大规模的数据进行提取、转换和加载,即通常所称的ETL(Extraction,Transformation,and Loading)操作。对庞大的数据集查询需要耗费大量的时间去处理,在许多场景下,可以通过建立Hive分区方法减少每一次扫描的总数据量,这种做法可以显著地改善性能。

Hive的分区使用HDFS的子目录功能实现,每一个子目录包含了分区对应的列名和每一列的值。当分区很多时,会有很多HDFS子目录,如果不依赖工具,将外部数据加载到Hive表各分区不是一件容易的事情。云数据迁移服务(CDM)可以请轻松将外部数据源(关系数据库、对象存储服务、文件系统服务等)加载到Hive分区表。

下面使用CDM将MySQL数据导入到MRS Hive分区表为例进行介绍。

操作场景

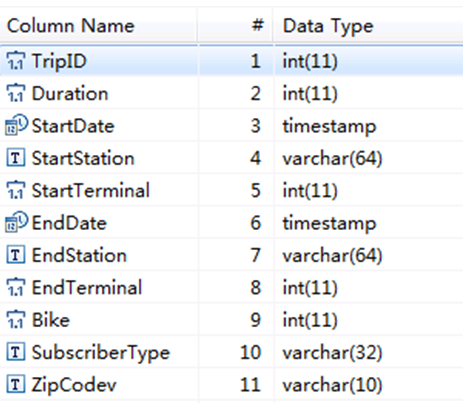

假设MySQL上有一张表trip_data,保存了自行车骑行记录,里面有起始时间、结束时间,起始站点、结束站点、骑手ID等信息,trip_data表字段定义如下图“MySQL表字段”所示。

使用CDM将MySQL中的表trip_data导入到MRS Hive分区表,流程如下:

1.在MRS Hive上创建Hive分区表

2.创建CDM集群并绑定EIP

3.创建MySQL连接

4.创建Hive连接

5.创建迁移作业

前提条件

- 已经创建MRS。

- 已获取连接MySQL数据库的IP地址、端口、数据库名称、用户名、密码,且该用户拥有MySQL数据库的读写权限。

- 已参考 管理驱动,上传了MySQL数据库驱动。

在MRS Hive上创建Hive分区表

在MRS的Hive上使用下面SQL语句创建一张Hive分区表,表名与MySQL上的表trip_data一致,且Hive表比MySQL表多建三个字段y、ym、ymd,作为Hive的分区字段。SQL语句如下:

create table trip_data(TripID int,Duration int,StartDate,timestamp,StartStation varchar(64),StartTerminal int,EndDate timestamp,EndStation varchar(64),EndTerminal int,Bike int,SubscriberType varchar(32),ZipCodev varchar(10))partitioned by (y int,ym int,ymd int);

说明Hive表trip_data有三个分区字段:骑行起始时间的年、骑行起始时间的年月、骑行起始时间的年月日,例如一条骑行记录的起始时间为2018/5/11 9:40,那么这条记录会保存在分区trip_data/2018/201805/20180511下面。对trip_data进行按时间维度统计汇总时,只需要对局部数据扫描,大大提升性能。

创建CDM集群并绑定EIP

- 参考创建CDM集群,创建CDM集群。

关键配置如下:

- CDM集群的规格,按待迁移的数据量选择,一般选择cdm.medium即可,满足大部分迁移场景。

- CDM集群所在VPC、子网、安全组,选择与MRS集群所在的网络一致。

- CDM集群创建完成后,选择集群操作列的“绑定弹性IP”,CDM通过EIP访问MySQL。

详见下图: 集群列表

说明如果用户对本地数据源的访问通道做了SSL加密,则CDM无法通过弹性IP连接数据源。

创建MySQL连接

- 在CDM集群管理界面,单击集群后的“作业管理”,选择“连接管理 > 新建连接”,进入连接器类型的选择界面。

- 选择“MySQL”后单击“下一步”,配置MySQL连接的参数。

单击“显示高级属性”可查看更多可选参数,具体请参见 配置常见关系数据库连接。这里保持默认,必填参数如下表“MySQL连接参数”所示。

| 参数名 | 说明 | 取值样例 |

|---|---|---|

| 名称 | 输入便于记忆和区分的连接名称。 | mysqllink |

| 数据库服务器 | MySQL数据库的IP地址或域名。 | 192.168.1.110 |

| 端口 | MySQL数据库的端口。 | 3306 |

| 数据库名称 | MySQL数据库的名称。 | sqoop |

| 用户名 | 拥有MySQL数据库的读、写和删除权限的用户。 | admin |

| 密码 | 用户的密码。 | - |

| 使用本地API | 使用数据库本地API加速(系统会尝试启用MySQL数据库的local_infile系统变量)。 | 是 |

| 使用Agent | 是否选择通过Agent从源端提取数据。 | 是 |

| local_infile字符集 | mysql通过local_infile导入数据时,可配置编码格式。 | utf8 |

| 驱动版本 | 适配mysql的驱动。 | - |

| Agent | 单击“选择”,选择连接Agent中已创建的Agent。 | - |

| 单次请求行数 | 指定每次请求获取的行数。 | 1000 |

| 单次提交行数 | 支持通过agent从源端提取数据 | 1000 |

| 连接属性 | 自定义连接属性。 | useCompression=true |

| 引用符号 | 连接引用表名或列名时的分隔符号。默认为空。 | ' |

| 单次写入行数 | 指定单次批量写入的行数,当写入行数累计到单次批量提交行数时提交一次,该值应当小于单次提交行数。 | 100 |

- 单击“保存”回到连接管理界面。

说明如果保存时出错,一般是由于MySQL数据库的安全设置问题,需要设置允许CDM集群的EIP访问MySQL数据库。

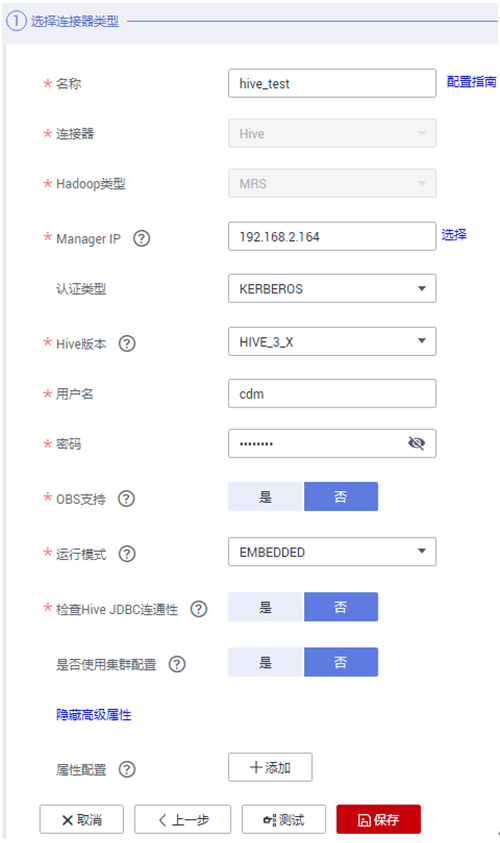

创建Hive连接

- 单击CDM集群后的“作业管理”,进入作业管理界面,再选择“连接管理 > 新建连接”,进入选择连接器类型的界面。

- 连接器类型选择“MRS Hive”后单击“下一步”配置Hive连接参数,如下图“创建MRS Hive连接”所示。

各参数说明如下表“MRS Hive连接参数”所示,需要您根据实际情况配置。

| 参数名 | 说明 | 取值样例 |

|---|---|---|

| 名称 | 连接的名称,根据连接的数据源类型,用户可自定义便于记忆、区分的连接名。 | mrs-link |

| Manager IP | MRS Manager的浮动IP地址,可以单击输入框后的“选择”来选定已创建的MRS集群,CDM会自动填充下面的鉴权参数。 | 127.0.0.1 |

| 认证类型 | 访问MRS的认证类型: SIMPLE:非安全模式选择Simple鉴权。 KERBEROS:安全模式选择Kerberos鉴权。 |

SIMPLE |

| Hive版本 | Hive的版本。根据服务端Hive版本设置。 | HIVE_3_X |

| 用户名 | 选择KERBEROS鉴权时,需要配置MRS Manager的用户名和密码。从HDFS导出目录时,如果需要创建快照,这里配置的用户需要HDFS系统的管理员权限。 如果要创建MRS安全集群的数据连接,不能使用admin用户。因为admin用户是默认的管理页面用户,这个用户无法作为安全集群的认证用户来使用。您可以创建一个新的MRS用户,然后在创建MRS数据连接时,“用户名”和“密码”填写为新建的MRS用户及其密码。 说明 如果CDM集群为2.9.0版本及之后版本,且MRS集群为3.1.0及之后版本,则所创建的用户至少需具备Manager_viewer的角色权限才能在CDM创建连接;如果需要对应组件的进行库、表、数据的操作,还需要添加对应组件的用户组权限。 如果CDM集群为2.9.0之前的版本,或MRS集群为3.1.0之前的版本,则所创建的用户需要具备Manager_administrator或System_administrator权限,才能在CDM创建连接。 仅具备Manager_tenant或Manager_auditor权限,无法创建连接。 |

cdm |

| 密码 | 访问MRS Manager的用户密码。 | - |

| OBS支持 | 需服务端支持OBS存储。在创建Hive表时,您可以指定将表存储在OBS中。 | 否 |

| 运行模式 | “HIVE_3_X”版本支持该参数。支持以下模式: EMBEDDED:连接实例与CDM运行在一起,该模式性能较好。 STANDALONE:连接实例运行在独立进程。如果CDM需要对接多个Hadoop数据源(MRS、Hadoop或CloudTable),并且既有KERBEROS认证模式又有SIMPLE认证模式,只能使用STANDALONE模式或者配置不同的Agent。 说明 STANDALONE模式主要是用来解决版本冲突问题的运行模式。当同一种数据连接的源端或者目的端连接器的版本不一致时,存在jar包冲突的情况,这时需要将源端或目的端放在STANDALONE进程里,防止冲突导致迁移失败。 |

EMBEDDED |

| 检查Hive JDBC连通性 | 是否需要测试Hive JDBC连通性。 | 否 |

| 是否使用集群配置 | 用户可以在“连接管理”处创建集群配置,用于简化Hadoop连接参数配置。 | 否 |

| 属性配置 | 其他Hive客户端配置属性。 | - |

- 单击“保存”回到连接管理界面。

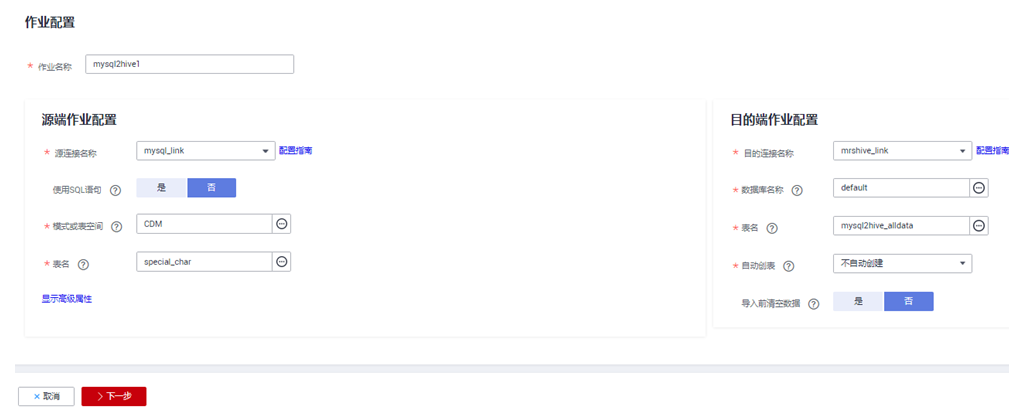

创建迁移作业

- 选择“表/文件迁移 > 新建作业”,开始创建数据迁移任务,如下图“创建MySQL到Hive的迁移任务”所示。

说明“导入前清空数据”选“是”,这样每次导入前,会将之前已经导入到Hive表的数据清空。

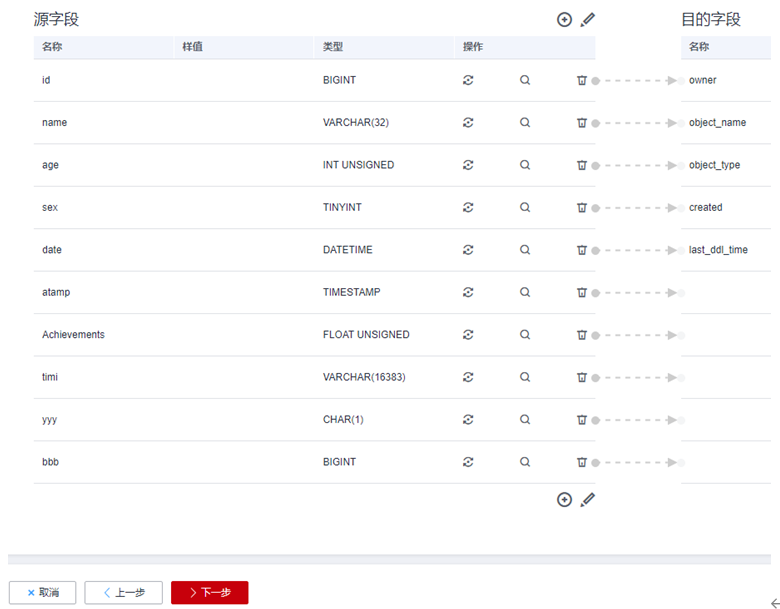

- 作业参数配置完成后,单击“下一步”,进入字段映射界面,如下图“Hive字段映射”所示。

映射MySQL表和Hive表字段,Hive表比MySQL表多三个字段y、ym、ymd,即是Hive的分区字段。由于没有源表字段直接对应,需要配置表达式从源表的StartDate字段抽取。

- 单击

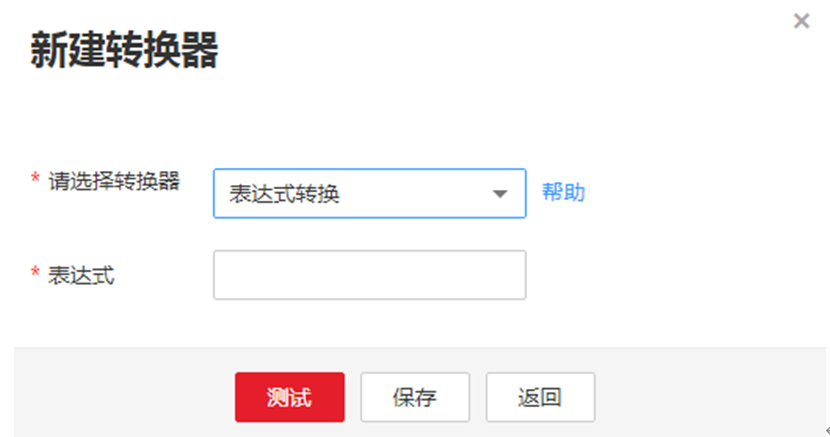

进入转换器列表界面,再选择“新建转换器 > 表达式转换”,如下图“配置表达式”所示。

进入转换器列表界面,再选择“新建转换器 > 表达式转换”,如下图“配置表达式”所示。

y、ym、ymd字段的表达式分别配置如下:

DateUtils.format(DateUtils.parseDate(row[2],"yyyy-MM-dd HH:mm:ss.SSS"),"yyyy")

DateUtils.format(DateUtils.parseDate(row[2],"yyyy-MM-dd HH:mm:ss.SSS"),"yyyyMM")

DateUtils.format(DateUtils.parseDate(row[2],"yyyy-MM-dd HH:mm:ss.SSS"),"yyyyMMdd")

说明CDM的表达式已经预置常用字符串、日期、数值等类型的字段内容转换。

- 单击“下一步”配置任务参数,一般情况下全部保持默认即可。

该步骤用户可以配置如下可选功能:

- 作业失败重试:如果作业执行失败,可选择是否自动重试,这里保持默认值“不重试”。

- 作业分组:选择作业所属的分组,默认分组为“DEFAULT”。在CDM“作业管理”界面,支持作业分组显示、按组批量启动作业、按分组导出作业等操作。

- 是否定时执行:如果需要配置作业定时自动执行,请参见 配置定时任务。这里保持默认值“否”。

- 抽取并发数:设置同时执行的抽取任务数。这里保持默认值“1”。

- 是否写入脏数据:如果需要将作业执行过程中处理失败的数据、或者被清洗过滤掉的数据写入OBS中,以便后面查看,可通过该参数配置,写入脏数据前需要先配置好OBS连接。这里保持默认值“否”即可,不记录脏数据。

- 作业运行完是否删除:这里保持默认值“不删除”。

- 单击“保存并运行”,回到作业管理界面,在作业管理界面可查看作业执行进度和结果。

- 作业执行成功后,单击作业操作列的“历史记录”,可查看该作业的历史执行记录、读取和写入的统计数据。

在历史记录界面单击“日志”,可查看作业的日志信息。