简述

云计算经过这么多年的发展,目前各大云厂商已经完成IAAS基础设施的建设和优化,开始向云原生、智算HPC等新方向的需求进行技术演进和迭代。网络作为云计算IAAS的三驾马车之一(计算、网络、存储),为计算和存储提供信息高速通路,在技术演进过程中也发生了翻天覆地的技术革新,本文就为大家简单介绍一下网络数据面技术的演进历史。

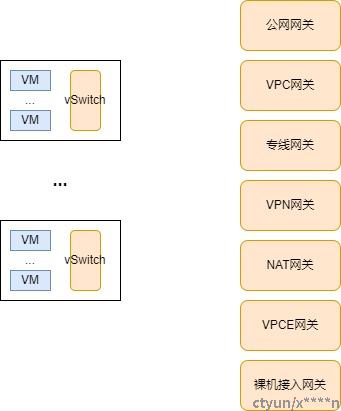

数据面组件说明

如上图,云内数据面组件主要包括两部分:

- 计算节点虚拟交换机

虚拟交换机直接承接虚机的网络出入流量,根据流表规则对虚机的流量做限速和各种网络转发策略,包括acl、安全组、HAVIP、流量镜像、dhcp、arp代答、流量封装隧道转发至各类网元。

- 网元节点

网元节点主要有如下:

公网网关:负责转发虚机的公网出入流量,对EIP的流量和共享带宽等进行限速,对于租户的eip执行bgp宣告等;

VPC网关:该网关是外部组件访问VPC的入口,既可以承接租户VPC的跨子网、同子网、对等连接等流量,还可以承接专线、VPN等流量流量;

VPN网关:该网关承接VPN产品的流量,是对专线业务的一个补充,通过对公网流量进行加密,客户可以安全的通过公网将云上VPC业务和线下IDC资源打通;

专线网关:该网关打通客户IDC和租户云上VPC通道,一般支撑大带宽的需求;

NAT网关:该网关负责对于无EIP的云主机提供公网访问需求;

VPCE网关:通过该网关将VPC私密地连接到终端节点服务,使VPC中的云资源无需弹性公网IP就能够访问服务提供方的服务;

裸机接入网关:该网关负责将裸机接入VPC,实现裸机与云主机、公网、专线等其他资源的流量互通需求;

虚拟交换机技术演进

计算节点VPC网络数据面最核心的组件就是vSwitch,vSwtich有开源实现也有各大云厂商的自研实现,但是技术演进上差别不大,依次都经历了如下阶段:

- 基于linux kernel的实现,开源代表有openvswitch.ko还有各大云厂商自研的内核模块实现;

- 基于dpdk,旁路linux kernel,流量路径由原来的:网卡->vSwitch.ko->qemu(vm)优化为:网卡->dpdk vSwitch ->qemu(vm);

- 基于DPU,进一步释放宿主机cpu资源,将vSwtich的逻辑卸载到DPU上,这样一方面释放宿主机cpu计算资源,另一方面提升了网络转发性能,包括带宽和延迟。

网元网关技术演进

总体上来讲,网元网关技术演进与vSwtich本质上是一致的,都经历了软转到硬转的技术迭代;

第一代:基于linux kernel,使用namespace等网络隔离技术,配置各种iptable规则这样来实现VPC的虚拟路由器;

第二代:随着DPDK技术的普及,各大厂商基于自己的业务逻辑,开始自研实现VPC的虚拟路由器及其各类网关;

第三代:随着可编程交换机的推出,对于T级别以上大带宽需求的场景,很多无状态网关采用可编程交换机进行实现,这样一方面降低成本,另一方面提升了性能,但是鉴于可编程交换机的表项容量限制,很多复杂的业务场景和配置大规格的场景需求难以满足,所以需要增加复杂调度逻辑,配合DPDK软转集群做精细化的调度,才能真正的实现效益提升。

未来数据面发展思考

未来数据面的技术发展,笔者认为是软硬协同,不论是在虚拟交换机还是网元网关;而且随着虚机交换机的软硬协同越来越彻底,流量隔离越彻底,网元会采用虚拟化的形态来提供服务,这样能够实现极致的弹性,为未来进一步的降本增效提供技术支撑。